A Microsoft acaba de inaugurar algo que parece ter saído de um filme de ficção científica: o Fairwater, o primeiro data center do mundo projetado especificamente para ser uma superfábrica de inteligência artificial em escala planetária. Localizado em Atlanta, Geórgia, esse complexo tecnológico representa o maior salto já visto na infraestrutura de IA e pode mudar completamente o jeito como desenvolvemos e usamos sistemas inteligentes.

Para entender a dimensão do que estamos falando, imagine um prédio capaz de processar mais de 865 mil tokens por segundo. Tokens são as unidades básicas de informação que os modelos de linguagem como o ChatGPT processam. Em termos práticos, significa que esse data center consegue ler e compreender o equivalente a milhares de livros em poucos segundos.

O Fairwater não é apenas mais um data center comum. É uma instalação construída do zero especificamente para atender à demanda explosiva por computação de Inteligência Artificial, integrando centenas de milhares das mais recentes GPUs NVIDIA GB300 em um único super computador gigantesco. Segundo a própria Microsoft, essa infraestrutura coloca a empresa em uma posição única para liderar a corrida global pela inteligência artificial.

Satya Nadella, CEO da Microsoft, afirmou recentemente que a empresa está unicamente posicionada para atender à demanda global de IA, enviando um recado direto a rivais como Google, Amazon e OpenAI. E ele não está exagerando. O investimento de 3,3 bilhões de dólares, cerca de 18 bilhões de reais, no projeto Fairwater demonstra o quanto a Microsoft está levando a sério sua ambição de dominar a infraestrutura que sustenta o futuro digital.

Como funciona a super fábrica de IA Fairwater

O conceito de superfábrica de IA é relativamente novo. Diferente dos data centers tradicionais em nuvem, que funcionam de forma mais fragmentada, o Fairwater utiliza uma única rede plana capaz de integrar centenas de milhares de GPUs em um supercomputador de grande porte. É como se fosse um cérebro eletrônico gigantesco, onde todos os neurônios artificiais trabalham em perfeita sincronia.

A infraestrutura foi conectada ao primeiro centro Fairwater em Wisconsin, a gerações anteriores de supercomputadores de IA e à ampla rede global de data centers da Azure, criando essa superfábrica de escala planetária. Essa conexão entre diferentes locais foi possível graças a uma rede óptica WAN dedicada exclusivamente para IA, com mais de 193 mil quilômetros de fibra óptica instalados apenas nos Estados Unidos no último ano.

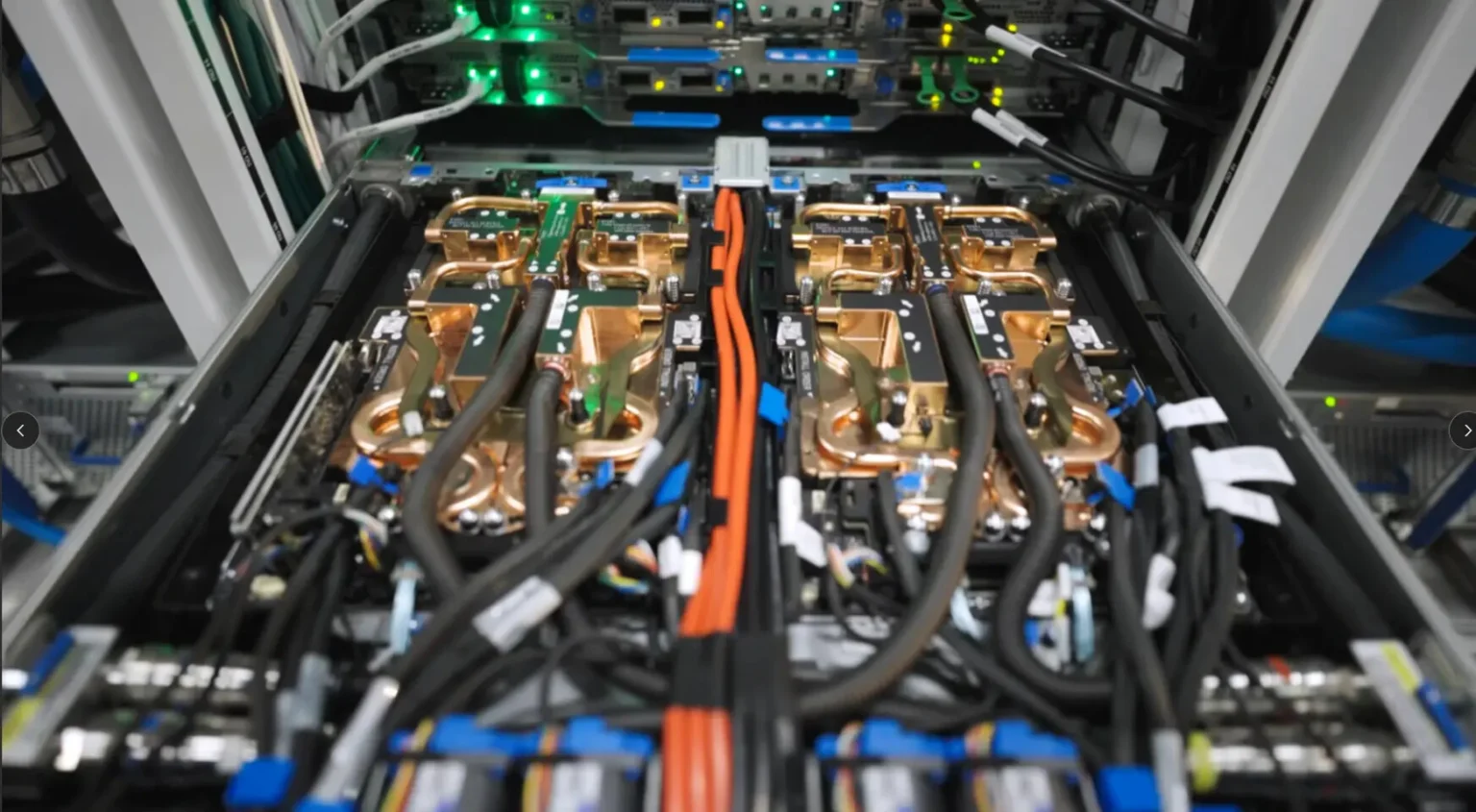

O segredo por trás da potência do Fairwater está em algo que os engenheiros chamam de densidade computacional máxima. Cada rack de servidor consegue concentrar aproximadamente 140 quilowatts de potência, o que é cerca de sete vezes mais do que um data center tradicional consegue. Multiplicando isso por centenas de racks organizados estrategicamente, você tem uma capacidade de processamento absurda.

Para conseguir essa densidade sem derreter tudo, a Microsoft precisou reinventar completamente o sistema de resfriamento. O Fairwater usa resfriamento líquido em circuito fechado, uma tecnologia onde um líquido especial circula continuamente pelos servidores absorvendo o calor diretamente das GPUs e depois dissipando esse calor em uma das maiores centrais de refrigeração do planeta.

A água usada no enchimento inicial do sistema equivale ao consumo de apenas 20 residências em um ano e só precisa ser substituída após análise química indicar necessidade, o que foi projetado para acontecer apenas depois de mais de seis anos. Isso torna o sistema extremamente eficiente e sustentável, uma preocupação cada vez mais importante considerando o impacto ambiental desses mega data centers.

O Design inovador de dois andares

Uma das inovações mais interessantes do Fairwater é sua arquitetura de dois andares. Enquanto data centers tradicionais são construídos em um único nível, o Fairwater distribui seus racks em duas camadas verticais, criando uma estrutura tridimensional.

Pode parecer um detalhe simples, mas essa escolha de design é genial. Muitas cargas de trabalho de IA são extremamente sensíveis à latência, que é o tempo que um sinal leva para viajar de um ponto a outro. Em termos práticos, cada centímetro de cabo adicional aumenta minimamente esse tempo, mas quando você está lidando com centenas de milhares de GPUs conversando entre si bilhões de vezes por segundo, esses milissegundos importam muito.

Ao posicionar os racks em três dimensões em vez de apenas duas, os engenheiros conseguiram minimizar drasticamente o comprimento dos cabos necessários para conectar todas as GPUs. É como se, em vez de construir uma cidade espalhada horizontalmente, você construísse arranha-céus concentrando tudo verticalmente, reduzindo as distâncias que as pessoas precisam percorrer.

Essa abordagem melhora a latência, aumenta a largura de banda disponível, melhora a confiabilidade do sistema e ainda reduz custos com cabeamento. Cada GPU no Fairwater está conectada a todas as outras GPUs, criando uma malha de comunicação incrivelmente densa e eficiente.

O Poder Bruto das GPUs NVIDIA GB300

No coração do Fairwater estão as GPUs NVIDIA Blackwell, mais especificamente o modelo GB300, que representa o processamento de inteligência artificial. Para quem não está familiarizado, GPUs são processadores especializados originalmente criados para gráficos de videogames, mas que se revelaram perfeitos para os cálculos matemáticos massivos que a IA exige.

A Microsoft anunciou recentemente que implantou o primeiro supercomputador do mundo equipado com sistemas NVIDIA GB300 NVL72. Esse sistema combina 72 GPUs Blackwell Ultra e 36 CPUs NVIDIA Grace em uma única unidade líquido-resfriada em escala de rack, atingindo incríveis 1,44 exaflops de desempenho.

Para colocar isso em perspectiva, um exaflop significa um quintilhão de operações de ponto flutuante por segundo. É um número tão grande que é difícil compreender. Imagine que cada pessoa no planeta Terra fizesse um milhão de cálculos matemáticos por segundo simultaneamente. Ainda assim, não chegaríamos nem perto do que um único rack desses consegue processar.

Cada rack do GB300 NVL72 possui 37 terabytes de memória ultrarrápida, criando um espaço de memória unificado voltado especificamente para modelos de raciocínio e IA generativa. Essa memória compartilhada é fundamental porque permite que as GPUs troquem informações instantaneamente, sem os gargalos que acontecem quando dados precisam ser movidos entre diferentes módulos de memória.

Os testes de desempenho mais recentes mostram que a nova arquitetura apresentou até cinco vezes mais throughput por GPU no modelo DeepSeek-R1 de 671 bilhões de parâmetros quando comparada à geração anterior Hopper. Para modelos gigantescos como o Llama 3.1 405B, o desempenho também foi superior em todos os benchmarks realizados.

A Rede que conecta tudo: InfiniBand e NVLink

Ter GPUs poderosas é apenas parte da equação. O verdadeiro desafio é conectá-las de forma que possam trabalhar como um único cérebro gigante. Para isso, a Microsoft implementou uma arquitetura de rede de dois níveis baseada nas tecnologias mais avançadas da NVIDIA.

Dentro de cada rack, o NVLink Switch de quinta geração oferece assombrosos 130 terabytes por segundo de largura de banda direta entre as 72 GPUs. Para ser mais claro, isso significa que todas as GPUs de um rack podem trocar informações entre si na velocidade da luz, literalmente. O NVLink funciona como uma super rodovia de informação onde não existem engarrafamentos.

Já para conectar todos os racks entre si, a Microsoft usa o NVIDIA Quantum-X800 InfiniBand, que garante 800 gigabits por segundo por GPU. Essa tecnologia conecta as mais de 4.600 GPUs do sistema, permitindo que se comuniquem de forma fluida mesmo estando fisicamente distantes.

A plataforma utiliza ainda recursos impressionantes de roteamento adaptativo, onde a rede escolhe automaticamente o melhor caminho para cada pacote de dados baseando-se em telemetria em tempo real. Há também controle de congestionamento inteligente e o protocolo SHARP v4, que realiza cálculos diretamente nos switches de rede, duplicando a largura de banda efetiva.

Essas tecnologias juntas oferecem controle avançado de congestionamento, detecção e retransmissão ultrarrápidas e balanceamento de carga ágil, garantindo desempenho ultraconfiável e de baixa latência para cargas de trabalho de IA modernas. É o tipo de infraestrutura necessária quando você está treinando modelos com centenas de trilhões de parâmetros.

Energia e sustentabilidade: Um desafio gigantesco

Um data center do tamanho e potência do Fairwater consome uma quantidade absurda de energia. Estamos falando de gigawatts de eletricidade funcionando continuamente. A potência total do complexo é equivalente ao consumo de uma cidade pequena.

A escolha de Atlanta como localização não foi casual. O local foi selecionado especificamente considerando a disponibilidade de energia da rede elétrica local, que é capaz de fornecer disponibilidade de quatro noves, ou seja, 99,99% de uptime. Isso significa que o data center fica sem energia por no máximo 52 minutos por ano.

Essa alta disponibilidade de energia da rede elétrica permitiu à Microsoft dispensar abordagens tradicionais de resiliência como geradores diesel no local, sistemas UPS enormes e distribuição com cabos duplos. Isso gerou economia significativa para os clientes e acelerou o lançamento do projeto.

No entanto, surge um problema interessante: quando você liga ou desliga milhares de GPUs simultaneamente para iniciar uma tarefa grande de treinamento, isso gera oscilações massivas de energia que podem desestabilizar a rede elétrica. É como se toda uma cidade acendesse todas as luzes ao mesmo tempo.

Para mitigar isso, a Microsoft desenvolveu três soluções em conjunto com parceiros do setor. A primeira é baseada em software e introduz cargas de trabalho suplementares durante períodos de atividade reduzida, mantendo o consumo mais estável.

A segunda é baseada em hardware, onde as próprias GPUs definem seus limites de energia dinamicamente. A terceira envolve armazenamento de energia local, tipo baterias gigantescas, para mascarar as flutuações sem usar energia excedente da rede.

Do ponto de vista ambiental, a eficiência energética do Fairwater é impressionante. O sistema de resfriamento líquido permite transferência de calor muito maior do que os sistemas de ar tradicionais, o que significa que menos energia é desperdiçada. Mais de 90% da operação ocorre sob esse modelo de circuito fechado, evitando evaporação de água e desperdício.

Da Teoria à prática: O que tudo isso significa

Toda essa tecnologia não existe apenas para quebrar recordes ou impressionar em apresentações. O objetivo final é permitir o desenvolvimento de modelos de IA cada vez mais avançados, capazes de tarefas que hoje parecem impossíveis.

A arquitetura do Fairwater foi desenvolvida especificamente para atender aos workloads mais exigentes da OpenAI, parceira estratégica da Microsoft. Isso inclui raciocínio multimodal, onde a IA consegue processar simultaneamente texto, imagem, áudio e vídeo de forma integrada, e inferência de grande escala, que é quando a IA usa um modelo já treinado para responder a perguntas ou realizar tarefas.

O projeto promete reduzir o tempo de treinamento de modelos de IA de meses para poucas semanas. Isso pode não parecer muito impressionante até você entender que cada semana economizada representa milhões de dólares em custos de computação e, mais importante, acelera o ritmo de inovação.

Modelos como o GPT-4 ou o Claude levaram meses para serem treinados usando infraestruturas anteriores. Com o Fairwater, modelos da próxima geração, potencialmente com trilhões de parâmetros, poderão ser desenvolvidos em fração desse tempo. Isso significa que veremos avanços em IA acontecendo numa velocidade muito maior do que nos últimos anos.

Nidhi Chappell, vice-presidente corporativa de infraestrutura de IA da Microsoft Azure, explicou que entregar o primeiro cluster de produção em larga escala com o NVIDIA GB300 NVL72 é um feito que ultrapassa a potência dos chips. Essa conquista reflete o esforço conjunto entre Microsoft e NVIDIA para otimizar cada camada do data center moderno e permitir que parceiros como a OpenAI avancem mais rápido.

Estratégia de Soberania Computacional

Por trás de todo esse investimento bilionário está uma estratégia clara: a Microsoft quer dominar completamente a cadeia produtiva da inteligência artificial. Isso é o que chamamos de soberania computacional, ou seja, independência total na produção e operação da tecnologia que alimenta sistemas de IA.

Se antes a disputa entre big techs girava em torno de quem tinha os modelos mais avançados, agora o foco mudou para quem controla o poder de processamento que torna esses modelos possíveis. E a Microsoft quer ser a rainha desse novo império.

A empresa não quer mais depender exclusivamente de fornecedores externos. Por isso, além de usar GPUs da NVIDIA, também está desenvolvendo seus próprios chips. Em 2023, a Microsoft lançou o Azure Maia AI Accelerator, voltado especificamente para cargas de trabalho de IA, e o Cobalt CPU, processador criado para rodar aplicações em servidores de alto desempenho.

Esses chips serão integrados à rede de mais de 300 data centers da Microsoft espalhados por 34 países, que já sustentam o serviço de nuvem Azure e produtos como o Copilot. Kevin Scott, CTO da Microsoft, resume a ambição: o objetivo é ter controle total do design do sistema às decisões de resfriamento, garantindo que cada peça da infraestrutura seja moldada para extrair o máximo da IA.

No entanto, há uma contradição interessante. Apesar de todo o discurso sobre independência, a Microsoft ainda depende fortemente da NVIDIA. Tanto o Fairwater quanto outros projetos operam com chips da fabricante, que continua dominando o mercado de GPUs de alto desempenho. Isso mostra que a autonomia total ainda é uma meta distante, não uma realidade atual.

A Tática do aluguel: Bilhões em nuvens terceirizadas

Enquanto constrói sua infraestrutura própria, a Microsoft também adota uma estratégia complementar inteligente: alugar poder computacional de terceiros. Nos últimos meses, a empresa firmou contratos que somam mais de 33 bilhões de dólares, cerca de 176 bilhões de reais, com provedores de infraestrutura conhecidos como neoclouds.

Empresas como Nebius, Nscale, Lambda e CoreWeave receberam contratos milionários para fornecer acesso a dezenas de milhares de chips NVIDIA. O maior desses acordos, com a Nebius, vale impressionantes 19,4 bilhões de dólares e garante acesso a mais de 100 mil chips NVIDIA GB300.

Essa estratégia serve para contornar a escassez global de chips e servidores de IA, que atualmente limita a expansão de todas as big techs. O poder computacional alugado é usado internamente pela Microsoft para treinar modelos e desenvolver produtos de IA, liberando seus próprios data centers para atender clientes corporativos.

Scott Guthrie, chefe da divisão de nuvem da Microsoft, explica que a empresa não quer ficar limitada em termos de capacidade. Segundo ele, a estratégia representa uma conquista de território no espaço da IA, garantindo poder de processamento enquanto o mercado global disputa cada servidor disponível.

É uma corrida armamentista tecnológica onde não importa apenas ter a melhor tecnologia, mas também ter acesso suficiente a ela. E a Microsoft está gastando bilhões para garantir que não ficará para trás.

Fungibilidade: A Flexibilidade que faz a diferença

Um conceito importante para entender a arquitetura do Fairwater é a fungibilidade, que significa a capacidade de realocar recursos dinamicamente de acordo com as necessidades. O treinamento de modelos de IA evoluiu de uma única tarefa monolítica para uma gama de cargas de trabalho com requisitos diferentes.

Hoje, treinar um modelo de IA envolve várias etapas: pré-treinamento, onde o modelo aprende padrões gerais de enormes quantidades de dados; ajuste fino, onde ele é especializado para tarefas específicas; aprendizado por reforço, onde aprende com feedback; e geração de dados sintéticos, onde cria novos dados de treinamento.

Cada uma dessas etapas tem necessidades computacionais diferentes. O pré-treinamento exige clusters massivos funcionando por semanas, enquanto o ajuste fino pode usar clusters menores por períodos mais curtos. A infraestrutura WAN dedicada para IA que a Microsoft implantou permite integrar cada site Fairwater a um sistema elástico mais amplo.

Leia Também

Isso significa que, em um determinado momento, parte da capacidade do Fairwater pode estar treinando um modelo gigantesco para a OpenAI, enquanto outra parte processa inferências para o Copilot e outra parte realiza ajuste fino de modelos especializados para clientes corporativos. Tudo dinamicamente alocado conforme a demanda, maximizando a utilização das GPUs no sistema combinado.

Esse nível permite maior flexibilidade. Antes, se você montasse um cluster para treinar um modelo específico, ele ficava ocioso depois que o treinamento terminava. Agora, esses recursos são imediatamente realocados para outras tarefas, garantindo que o investimento bilionário em hardware está sempre sendo usado produtivamente.

O Impacto Global: Uma nova corrida armamentista

A inauguração do Fairwater e a implantação do GB300 NVL72 não são apenas marcos tecnológicos da Microsoft. Eles representam o início de uma nova corrida armamentista global pela infraestrutura de IA, com implicações econômicas e geopolíticas profundas.

Controlar o poder de processamento significa definir quem terá acesso aos modelos mais avançados e a que custo. Países que dominarem essa infraestrutura terão vantagens estratégicas enormes em inteligência, economia, defesa e praticamente todas as áreas da sociedade moderna.

Os Estados Unidos estão claramente à frente nessa corrida, com empresas como Microsoft, Google e Amazon investindo centenas de bilhões em data centers de IA. A China também está acelerando investimentos, apesar das restrições ocidentais à exportação de chips avançados. A Europa, historicamente forte em regulação mas mais fraca em execução tecnológica, corre o risco de ficar para trás.

Para a Microsoft especificamente, o sucesso dessa estratégia pode redefinir o equilíbrio de forças entre as big techs. A empresa está tentando se posicionar não apenas como uma fornecedora de nuvem, mas como a arquiteta da nova era da IA. Se conseguir, estabelecerá um novo padrão de soberania digital onde o verdadeiro poder não está no software, mas na energia e nos servidores que o mantêm funcionando.

Rani Borkar, presidente de hardware e infraestrutura da Azure, resume bem: construir para a era da IA exige repensar todos os níveis da pilha, do silício ao software. Esse projeto representa o início de uma nova fase de supercomputação em nuvem.

O Que isso significa para você

Você pode estar pensando: tudo isso é impressionante, mas o que muda na minha vida? A resposta é: praticamente tudo, eventualmente.

O Fairwater e infraestruturas similares estão viabilizando a próxima geração de assistentes de IA, muito mais capazes que o ChatGPT ou Copilot atuais. Estamos falando de sistemas que poderão entender contexto complexo, raciocinar através de problemas difíceis, integrar informações de múltiplas fontes e fornecer respostas verdadeiramente personalizadas.

Na medicina, modelos treinados nessa infraestrutura poderão analisar exames médicos com precisão sobre-humana, sugerir tratamentos personalizados baseados no seu genoma específico e prever doenças antes que sintomas apareçam. Na educação, tutores de IA poderão se adaptar perfeitamente ao estilo de aprendizado de cada estudante.

No trabalho, ferramentas de IA integradas a todos os aplicativos que você usa diariamente se tornarão tão naturais quanto corretores ortográficos são hoje. Escrever relatórios, analisar dados, criar apresentações, programar, projetar – tudo ficará mais rápido e acessível.

Haverá também impactos negativos que precisamos estar atentos. Desemprego em certas áreas, especialmente trabalho cognitivo repetitivo, é inevitável. Questões de viés algorítmico amplificado, desinformação gerada por IA em escala industrial e vigilância automatizada são riscos reais que as sociedades precisarão enfrentar.

A concentração de poder nas mãos de poucas empresas que controlam essa infraestrutura é outra preocupação legítima. Se a Microsoft, a Google e a Amazon controlam os supercomputadores necessários para treinar modelos de IA de ponta, elas efetivamente controlam o futuro da tecnologia. Isso levanta questões democráticas importantes sobre quem deve ter acesso e em que termos.

O Futuro está sendo construído agora

O Fairwater não é apenas um data center impressionante ou um projeto bilionário de uma grande empresa de tecnologia. É um símbolo tangível de que estamos entrando em uma nova era da computação, onde a inteligência artificial deixa de ser uma promessa futurista e se torna a infraestrutura básica sobre a qual a civilização moderna vai operar.

A capacidade de processar centenas de trilhões de parâmetros, treinar modelos em semanas em vez de meses, e integrar sistemas de IA em escala planetária vai acelerar o desenvolvimento tecnológico de forma que ainda não compreendemos completamente. Estamos potencialmente nos aproximando de um ponto de inflexão onde a IA começa a contribuir significativamente para seu próprio desenvolvimento.

A Microsoft está apostando bilhões de dólares que esse futuro está chegando rápido e que quem controlar a infraestrutura necessária para viabilizá-lo terá uma vantagem estratégica imensa. O tempo dirá se essa aposta valerá a pena, mas uma coisa é certa: o mundo que conhecemos está mudando, e tecnologias como o Fairwater são as ferramentas que estão construindo o próximo capítulo da história humana.

Para nós, usuários finais e cidadãos, cabe acompanhar essas mudanças com uma mistura de entusiasmo e cautela. O potencial para melhorar vidas é imenso, mas também o é o potencial para novos tipos de problemas e desigualdades. A tecnologia está evoluindo em velocidade vertiginosa, e garantir que essa evolução beneficie toda a humanidade, não apenas alguns poucos privilegiados, é o grande desafio do nosso tempo.

O Fairwater é mais que um data center. É uma janela para o futuro. E esse futuro está sendo construído agora, um chip de cada vez, um rack de cada vez, um exaflop de cada vez.