Imagine acordar um dia e descobrir que uma versão digital perfeita da sua voz foi criada por criminosos e usada para convencer seu gerente de banco a autorizar uma transferência. Ou que um hacker usou um chatbot de inteligência artificial para planejar e executar automaticamente um ataque contra dezenas de empresas, tudo sem precisar escrever uma única linha de código manualmente.

Isso não é mais ficção científica, é a realidade dos ataques cibernéticos em 2025 e com previsão de um aumento significativo em 2026.

A Nova Era dos Ataques Cibernéticos: Quando a IA se torna uma arma

A inteligência artificial mudou completamente as regras do jogo na segurança digital. Se antes os hackers precisavam de anos de conhecimento técnico especializado para executar ataques sofisticados, agora podem simplesmente conversar com um modelo de linguagem que faz o trabalho pesado por eles. E o mais preocupante: isso está acontecendo neste exato momento, em escala global.

Relatórios recentes da Google Cloud, Verizon, ABIN e outras organizações de segurança convergem para uma conclusão alarmante: 2026 marcará o ponto de virada onde o uso da IA por criminosos deixa de ser exceção e se torna regra. Estamos falando de um salto qualitativo e quantitativo nos ataques cibernéticos com Inteligência Artificial que podem pegar empresas e usuários completamente despreparados.

Dados recentes mostram que os ciberataques impulsionados por IA aumentaram impressionantes 72% entre 2024 e 2025, saltando de 10.870 para 16.200 incidentes globais confirmados. Mas o número real provavelmente é muito maior, considerando que muitos ataques nunca são detectados ou reportados publicamente.

Uma pesquisa da Veeam com mais de 250 executivos seniores de TI revelou que 45% deles consideram ameaças cibernéticas o principal fator de disrupção para 2026, superando até mesmo preocupações com custos operacionais ou escassez de talentos. Quando questionados sobre os riscos para os quais se sentem menos preparados, ciberataques e falhas relacionadas à automação de IA lideram a lista.

O Cybersecurity Forecast 2026 da Google Cloud é direto: a previsão é que o uso da ferramenta por agentes de ameaças passe da exceção para a regra, transformando o cenário global de ameaças cibernéticas. Não é mais questão de se isso vai acontecer, mas de quando você ou sua empresa serão alvos.

O Surgimento dos Agentes Autônomos de Ataque

A evolução mais alarmante no uso malicioso de IA é o surgimento de agentes autônomos, sistemas que operam de forma independente sem a necessidade de intervenção humana. Diferente das ferramentas tradicionais de automação, esses agentes conseguem planejar, executar e adaptar ataques inteiros baseando-se no que encontram pelo caminho.

Um relatório da Unit 42, equipe de inteligência de ameaças da Palo Alto Networks, identificou que cibercriminosos já estão usando agentes de IA para lançar ataques autônomos e adaptáveis. Esses sistemas conseguem tomar decisões baseadas no ambiente que encontram, reavaliar suas ações e até colaborar entre si para alcançar objetivos complexos.

A Anthropic documentou o que considera o primeiro uso conhecido de orquestração baseada em IA para combinar diferentes partes de malware e realizar reconhecimento de rede, descobrir vulnerabilidades, mover-se lateralmente em uma rede alvo e coletar dados, tudo de forma coordenada e automatizada. Eles chamam essa técnica de vibe hacking.

Leia Mais: PIX ganha novo mecanismo para recuperar dinheiro de vítimas de fraudes: Entenda como funciona

Imagine um invasor digital que funciona como um enxame de robôs microscópicos. Cada parte é relativamente simples, mas quando trabalham juntas sob coordenação da IA, conseguem realizar tarefas extremamente complexas.

Esses agentes podem varrer milhares de sistemas procurando brechas, testar automaticamente centenas de combinações de usuário e senha, adaptar suas técnicas quando encontram defesas e até mesmo aprender com tentativas anteriores.

O impacto prático disso é devastador. Ataques que antes levariam dias ou semanas para serem planejados e executados agora acontecem em horas. Sistemas que exigiriam equipes inteiras de hackers especializados podem ser comprometidos por um único criminoso usando agentes de IA como ajudantes digitais incansáveis.

Agentes Autônomos: IA que ataca sozinha 24 horas por dia

Estamos falando de malware que aprende, evolui e toma decisões por conta própria. Tradicionalmente, mesmo com ferramentas automatizadas, ataques cibernéticos exigiam uma supervisão humana constante.

Um hacker precisava tomar decisões sobre qual vulnerabilidade explorar, como contornar defesas específicas encontradas, quando mudar de tática se algo não funcionasse. Agora, agentes de IA podem fazer tudo isso autonomamente, operando 24 horas por dia, sete dias por semana, sem pausas nem erros por fadiga.

Um agente autônomo de IA pode, por exemplo, escanear continuamente a internet procurando por servidores vulneráveis. Quando encontra um alvo promissor, automaticamente testa diferentes vetores de ataque até conseguir acesso.

Uma vez dentro do sistema, ele próprio analisa a arquitetura da rede, identifica os dados mais valiosos, planeja a melhor rota de exfiltração e executa o roubo. Tudo sem nenhum humano envolvido além da configuração inicial.

A ABIN, Agência Brasileira de Inteligência, destaca em seu relatório “Desafios de Inteligência para 2026” que a rápida evolução da IA pode fazer desta ferramenta um agente ofensivo autônomo, capaz de planejar, executar e adaptar ataques. A agência alerta ainda que essa escalada pode fazer com que incidentes cibernéticos resultem até mesmo em conflitos militares, dada a capacidade potencial destrutiva.

O uso de sistemas de agentes para automatizar etapas ao longo do ciclo de ataque durante períodos longos representa uma mudança de paradigma. Criminosos podem lançar centenas ou milhares de ataques simultâneos com supervisão mínima, aumentando exponencialmente a escala de suas operações enquanto reduzem custos e riscos.

Vibe Hacking: Quando o ChatGPT vira hacker profissional

Um dos casos mais emblemáticos e assustadores envolveu um criminoso que usou um chatbot avançado para orquestrar uma campanha completa de ataques e extorsões contra múltiplas organizações simultaneamente. Pesquisadores já batizaram esse tipo de operação de vibe hacking, e o termo traduz perfeitamente a natureza quase que casual desses ataques automatizados.

O que torna esse caso particularmente preocupante é a abrangência do papel da IA. O criminoso não usou o modelo apenas para uma tarefa específica, mas para todo o ciclo de ataque.

Primeiro, pediu para o chatbot realizar varreduras de rede e identificar vulnerabilidades. Depois, solicitou que gerasse códigos de malware personalizados para explorar essas brechas. Em seguida, fez com que organizasse e categorizasse as informações roubadas. Por fim, até as mensagens de extorsão enviadas para cada vítima foram escritas pela IA, personalizadas com detalhes específicos de cada empresa.

O resultado? Um único criminoso, provavelmente sem conhecimento técnico profundo, conseguiu atacar dezenas de alvos com a eficiência de uma equipe inteira de hackers experientes. Ele não apenas acelerou todas as etapas de um ataque complexo, mas também reduziu drasticamente a necessidade da expertise especializada.

Isso democratiza o cibercrime de uma forma nunca vista antes. Tradicionalmente, ataques sofisticados exigiam hackers com anos de experiência em programação, redes e segurança. Agora, qualquer pessoa com intenções maliciosas e acesso a ferramentas de IA generativa pode potencialmente causar danos significativos. É como se tivéssemos entregado armas poderosas para qualquer um que as quisesse usar.

Deepfakes e Vishing: Sua voz é usada contra você

Se você acha que consegue identificar uma ligação falsa quando recebe, prepare-se para rever esse conceito. A nova geração de ataques usa clonagem de voz super realista impulsionada por IA, tornando praticamente impossível distinguir uma ligação legítima de uma fraudulenta apenas pelo áudio.

A técnica, conhecida como vishing (combinação de voz com phishing), usa clonagens de voz por IA para criar imitações hiper-realistas de executivos ou membros da equipe de TI de uma empresa.

Imagine receber uma ligação aparentemente do seu CEO pedindo que você autorize uma transferência urgente. A voz é idêntica, o tom é o mesmo. Como você saberia que não é realmente a pessoa?

Casos reais já mostraram o quão devastadores esses ataques podem ser. Em um incidente recente na Europa, criminosos clonaram a voz de um diretor financeiro usando apenas alguns minutos de áudio extraídos de vídeos públicos da empresa para instruir pagamento de um valor de seis dígitos.

Com essa voz sintética, ligaram para o departamento de tesouraria se passando pelo executivo e autorizaram uma transferência do valor. Quando o verdadeiro diretor descobriu, o dinheiro já havia sido dispersado por dezenas de contas em diferentes países.

A tecnologia de clonagem de voz evoluiu muito nos últimos dois anos. Antigamente, eram necessárias horas de gravações de alta qualidade para criar uma voz sintética convincente. Hoje, com apenas alguns minutos de áudio, que podem ser facilmente obtidos de vídeos no YouTube, conferências gravadas ou até de mensagens de áudio do WhatsApp, é possível gerar uma cópia perfeita.

O relatório da Verizon, que analisou mais de 22 mil incidentes de segurança em 2025, confirma a tendência preocupante: a utilização da Inteligência Artificial Generativa para criação de ataques sofisticados dobrou em comparação aos anos anteriores.

E os deepfakes não se limitam apenas a voz. Vídeos falsos de executivos dando instruções, documentos forjados com assinaturas perfeitas e até reuniões virtuais inteiras com pessoas que não existem já fazem parte do arsenal dos criminosos.

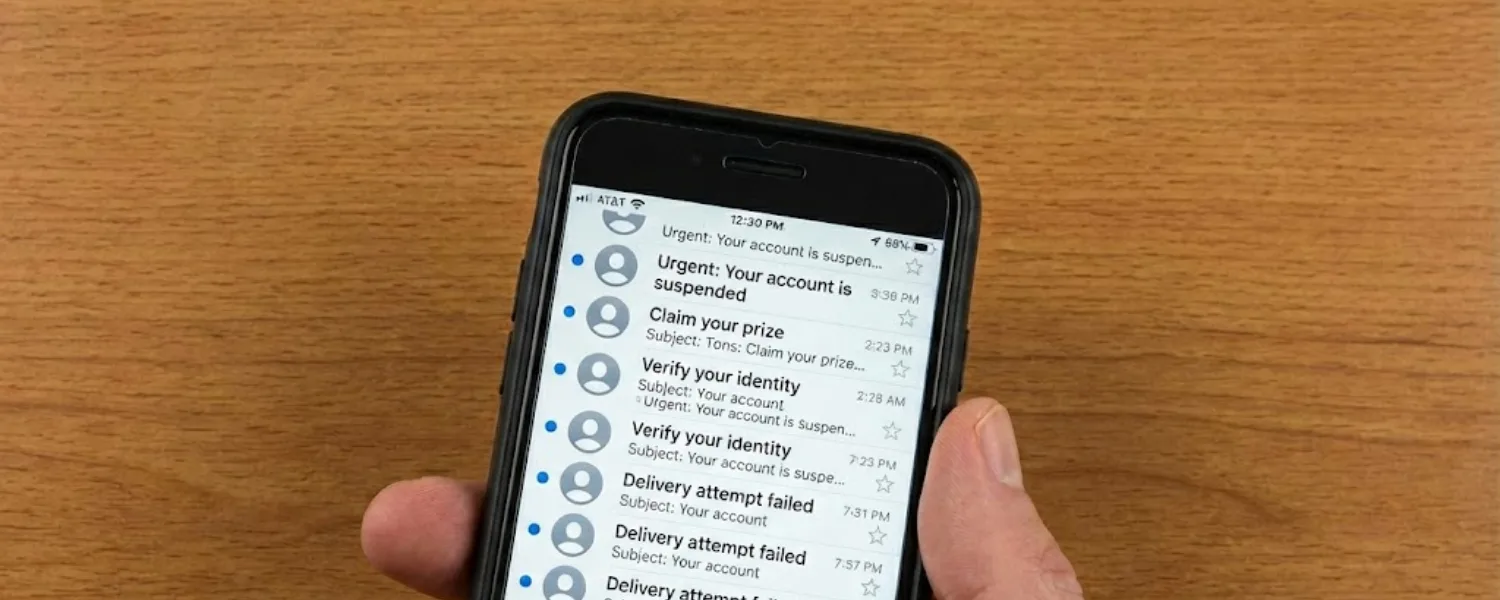

Engenharia Social e Phishing evoluídos: Mensagens que parecem genuínas

O phishing tradicional, aquele email mal escrito cheio de erros gramaticais avisando que você ganhou um prêmio ou que sua conta foi suspensa, está evoluindo rapidamente. Graças à IA generativa, as mensagens fraudulentas agora são indistinguíveis de comunicações legítimas.

Chatbots avançados já foram flagrados indicando falsos links de login de bancos e serviços online, redirecionando usuários desavisados para páginas de phishing hospedadas em domínios parecidos ou até mesmo em plataformas conhecidas e confiáveis.

Testes recentes revelaram que chatbots de IA devolveram endereços incorretos para páginas de login de grandes marcas, muitos deles não registrados, permitindo que criminosos comprem esses domínios e criem páginas falsas praticamente entregues de bandeja.

A personalização é a arma mais poderosa dessa nova geração de phishing. A IA consegue analisar perfis públicos em redes sociais, histórico de compras vazado e até padrões de comunicação para criar mensagens sob medida para cada vítima.

Não é mais um email genérico enviado para milhões. É uma mensagem especificamente para você, mencionando seu nome, seu cargo, projetos recentes em que trabalhou e escrita no tom que seus colegas normalmente usam.

O link parece correto, o remetente aparentemente é do domínio da empresa, o tom da mensagem é idêntico ao do seu colega. Você clicaria? A maioria das pessoas clicaria, e é exatamente nisso que os criminosos estão contando.

Em ataques a contas bancárias, essas técnicas são combinadas com mensagens personalizadas adaptadas ao perfil e à linguagem da vítima, aumentando as chances de que a pessoa entregue as credenciais, códigos de autenticação ou até autorize transferências financeiras sem desconfiar.

A Proofpoint antecipa que em 2026 os atacantes continuarão inovando para tornar técnicas de phishing ainda mais difíceis de identificar. A empresa prevê o uso intensivo de sites legítimos que incorporam conteúdo gerado rapidamente com IA, que os cibercriminosos usarão para criar documentos com aparência oficial que redirecionam para páginas de phishing ou para distribuírem malware.

Cloaking: Malware Invisível que engana Scanners de Segurança

Outra tática que ganhou sofisticação com o uso de IA é o cloaking, onde sites e códigos maliciosos conseguem detectar quando estão sendo analisados por ferramentas de segurança e se comportam de forma completamente diferente dependendo de quem está olhando.

Funciona assim: quando um scanner automatizado de segurança ou um navegador com proteções ativas acessa uma página maliciosa, o sistema detecta e mostra uma versão completamente limpa e inofensiva. Mas quando um usuário real, sem proteções avançadas, acessa o mesmo endereço, ele vê o conteúdo verdadeiro: phishing, malware, golpes.

Com apoio da IA, esse processo se torna muito mais sofisticado. Os modelos ajudam a gerar versões dinâmicas e ofuscadas de códigos maliciosos que mudam constantemente, tornando a detecção por assinatura praticamente impossível.

A IA altera padrões de código, substitui funções por equivalentes semanticamente idênticos mas sintaticamente diferentes, modifica assinaturas digitais e simula comportamento legítimo de forma cada vez mais convincente.

Na prática, isso significa que páginas de phishing e sites distribuindo malware conseguem permanecer online por muito mais tempo, enganando tanto usuários quanto ferramentas de segurança. Enquanto sistemas tradicionais levavam horas ou dias para identificar e bloquear uma ameaça, agora o malware pode permanecer ativo por semanas ou meses, vitimando milhares de pessoas antes de ser descoberto.

A ofuscação gerada por IA também torna a análise forense muito mais difícil. Quando pesquisadores de segurança finalmente conseguem capturar uma amostra do malware, descobrem que cada variante é ligeiramente diferente, dificultando a criação de defesas genéricas que funcionem contra todas as versões.

Ransomware e Extorsão: Ainda mais destrutivos em 2026

Se você pensava que o ransomware já era ruim, espere até ver a versão potencializada de ataques cibernéticos com a inteligência artificial. O ransomware continua sendo o tipo de cibercrime financeiramente mais disruptivo, e a IA está tornando esses ataques ainda mais eficientes e lucrativos.

O primeiro trimestre de 2025 registrou o maior número de vítimas já listadas em sites de vazamento de dados desde o início do monitoramento em 2020, evidenciando a maturidade assustadora do ecossistema de extorsão cibernética.

O modelo de negócio dos criminosos evoluiu. Antes, o foco era criptografar seus dados e exigir pagamento para devolvê-los. Agora, a tendência é roubar informações sensíveis e ameaçar com o vazamento público caso o resgate não seja pago. Para os criminosos, é um modelo mais simples, mais barato e igualmente eficaz. Não precisa nem criptografar nada, basta copiar e ameaçar expor.

As campanhas de ransomware aprimoradas por IA reduziram o tempo de permanência mediano, ou seja, quanto tempo os atacantes ficam dentro dos sistemas antes de serem detectados, de 9 dias para apenas 5 dias no primeiro semestre de 2025. Isso significa que há menos tempo para detectar e interromper o ataque antes que os dados sejam roubados ou os sistemas sejam criptografados.

O impacto desses ataques vai muito além da vítima. Em 2025, ataques que atingiram pontos críticos das cadeias de suprimentos de varejo e atacado de alimentos geraram prejuízos que somaram centenas de milhões de dólares, afetando fornecedores, clientes e comunidades inteiras.

Segundo a Tenable, empresa especializada em cibersegurança, não há sinal de que o ransomware vá desaparecer em 2026. O que deve mudar é o estilo, com menos foco em criptografar dados e mais ênfase em roubo de informações e extorsão direta, explorando a ameaça de vazamento público.

O Perigo que vem de dentro: IA Shadow e o Vazamento de dados

Um risco frequentemente subestimado é o uso crescente de agentes de IA por funcionários para executar tarefas, independentemente de aprovação corporativa. A Google alerta que isso criará fluxos invisíveis e sem controle para dados sensíveis, com potencial para vazamentos de informação, violações de compliance e roubo de propriedade intelectual.

Pense na seguinte situação: um funcionário bem-intencionado quer acelerar seu trabalho e passa a usar um chatbot público para redigir e-mails, resumir documentos ou analisar dados. Sem perceber, ele pode estar enviando informações confidenciais da empresa para servidores externos onde ficam armazenadas e potencialmente acessíveis a terceiros.

Esse fenômeno, chamado às vezes de Shadow IA, é similar ao problema de Shadow IT que empresas enfrentaram na década passada, mas potencialmente muito mais perigoso. Enquanto Shadow IT envolvia funcionários usando aplicativos não autorizados, Shadow IA significa dados corporativos sendo processados por sistemas de inteligência artificial fora do controle da empresa.

O Google Cloud adverte que banir agentes de IA não é uma opção viável, pois apenas empurra o uso para fora da rede corporativa e elimina completamente a visibilidade. Em vez disso, empresas precisam criar um novo modelo de segurança e governança para IA, baseado no princípio do secure by design, onde sistemas já nascem pensados para serem seguros.

Isso inclui ferramentas capazes de controlar, direcionar e acompanhar com segurança tudo que agentes de IA fazem na rede. Organizações bem-sucedidas criarão ambientes que permitam inovação com IA sem abrir mão da segurança auditável.

Ataques à Cadeia de Suprimentos: O Elo mais fraco

Cada novo software, plugin, API ou fornecedor de serviços que sua empresa usa representa uma potencial porta de entrada para cibercriminosos. Os ataques à cadeia de suprimentos, onde invasores comprometem um fornecedor confiável para atingir múltiplos clientes desse fornecedor, tendem a piorar significativamente em 2026.

Do ponto de vista da superfície de ataque, o ecossistema digital das empresas nunca foi tão amplo e tão difícil de monitorar. A participação de terceiros nos ataques dobrou entre 2024 e 2025, atingindo 30% dos casos, mostrando que criminosos estão cada vez mais explorando essas relações de confiança.

Setores como finanças, indústria e saúde permanecem no centro da tempestade, pois operam em ambientes altamente conectados, com sistemas legados difíceis de atualizar, múltiplas integrações e dependência crítica de terceiros.

É a combinação perfeita para que uma simples brecha digital se traduza em um impacto direto no mundo físico, seja na interrupção de operações críticas ou na indisponibilidade de serviços essenciais à população.

Pesquisa recente indica que 88% dos executivos consideram extremamente importante ou moderadamente importante garantir que parceiros e fornecedores atendam aos mesmos padrões rigorosos de cibersegurança e proteção de dados que a própria empresa em 2026. Mas garantir isso na prática é extremamente desafiador quando você depende de dezenas ou centenas de fornecedores diferentes.

O que dizem os números: Dados alarmantes de 2025

Os relatórios mais recentes pintam um quadro preocupante da situação atual, que serve como base para projeções ainda piores para 2026.

O Verizon DBIR 2025 analisou mais de 22 mil incidentes de segurança e registrou 12.195 violações confirmadas, o maior número já contabilizado na série histórica. Alguns dados abaixo são especialmente preocupantes:

- 22% das violações envolveram abuso de credenciais

- 20% exploraram vulnerabilidades conhecidas

- O fator humano esteve presente em 60% dos incidentes

- A participação de terceiros nos ataques dobrou, atingindo 30%

- Na América Latina, 84% das violações foram motivadas por ganhos financeiros

A pesquisa do Gartner revelou que 29% dos líderes de cibersegurança disseram que suas organizações sofreram um ataque à infraestrutura de aplicações de IA generativa nos últimos 12 meses. Além disso, 62% das organizações sofreram ataques com deepfakes envolvendo engenharia social, e 32% enfrentaram ataques a aplicações de IA que exploraram prompts.

A Experian reportou que no primeiro semestre de 2025 foram registrados mais de 8 mil vazamentos de dados no mundo, expondo cerca de 345 milhões de registros. Um em cada quatro foi vítima de roubo de identidade no último ano, e quase um quarto caiu em ataques de phishing.

Talvez o dado mais preocupante: mais de quatro em cada cinco pessoas estão preocupadas com o uso de IA para criar identidades falsas indistinguíveis das reais. E 69% não acreditam que o seu banco ou varejista esteja preparado adequadamente para se defender contra ataques cibernéticos de IA, ou não têm certeza.

Como a ABIN vê os riscos para o Brasil

A Agência Brasileira de Inteligência identificou ataques cibernéticos autônomos com inteligência artificial como um dos cinco principais desafios para 2026, junto com a segurança eleitoral, transição para criptografia pós-quântica, reconfiguração de cadeias de suprimentos e dependência tecnológica.

O contexto geopolítico aumenta a preocupação. Luiz Fernando Corrêa, diretor-geral da ABIN, destacou a competição acirrada pela dianteira no desenvolvimento e uso da IA, com o cenário atual caracterizado por multipolaridade desequilibrada tendo como fator central a competição estratégica entre EUA e China.

Para o Brasil, isso significa que ataques cibernéticos podem ser não apenas criminosos buscando lucro, mas também atores estatais ou para-estatais com objetivos geopolíticos. A proximidade das eleições de 2026 adiciona uma camada extra de preocupação, com possibilidade de interferência externa voltada a desestabilizar o processo eleitoral.

A ABIN também chama atenção para outro risco iminente: a computação quântica. A agência antevê que, no prazo de 5 a 15 anos, computadores quânticos tornarão obsoleta a atual criptografia de chaves públicas. Isso significa que toda a segurança digital como conhecemos, baseada em criptografia RSA e similares, poderá ser quebrada.

Nesse sentido, a ABIN considera urgente uma transição para algoritmos pós-quânticos que não dependam de tecnologias estrangeiras. É uma questão de soberania nacional digital, garantindo que o Brasil possa proteger suas comunicações sensíveis independentemente de soluções importadas.

Armas Biológicas e Químicas: Quando a IA cruza as linhas perigosas

O International AI Safety Report 2025 trouxe um alerta particularmente assustador: modelos avançados de IA já demonstram potencial para facilitar o desenvolvimento de armas biológicas e químicas.

Em experimentos controlados, um sistema de IA obteve melhor desempenho que especialistas humanos na elaboração de planos para produção de armas biológicas. Esse resultado foi tão preocupante que levou uma grande empresa do setor a aumentar sua classificação de risco biológico de baixo para médio.

Não estamos falando apenas de IA ajudando hackers a roubar dados ou dinheiro. Estamos falando de sistemas que podem potencialmente ajudar grupos terroristas ou estados hostis a desenvolver agentes patogênicos mortais ou substâncias químicas perigosas. É uma escalada de risco que vai muito além do cibercrime tradicional.

O relatório destaca que há grande descompasso entre o que empresas desenvolvedoras de IA sabem sobre seus sistemas e o que governos e pesquisadores independentes têm acesso. Essa assimetria de informações dificulta drasticamente a criação de políticas públicas eficazes para mitigar riscos emergentes.

Diante desse cenário, especialistas defendem a implementação de estratégias de mitigação mais robustas, incluindo técnicas de monitoramento contínuo dos modelos de IA, exigência de auditorias de segurança antes do lançamento de novas tecnologias e criação de regulamentações internacionais para garantir o uso responsável.

Regulação: A Corrida contra o tempo

A rápida evolução da IA está criando um problema regulatório. Muitos avanços ocorrem mais rapidamente do que governos conseguem responder, resultando em lacunas regulatórias especialmente em relação a novas capacidades da IA.

Algumas jurisdições estão mais avançadas que outras. A União Europeia aprovou o AI Act, primeira legislação abrangente sobre IA no mundo. A China implementou regulações estritas sobre algoritmos e deep synthetics. Estados Unidos e Canadá têm iniciativas em desenvolvimento, mas com abordagens mais fragmentadas.

O desafio é global e exige uma coordenação internacional. Um Malware criado em um país pode afetar vítimas do outro lado do planeta em segundos. Regulamentações puramente nacionais são insuficientes quando a internet não tem fronteiras.

Akif Khan, vice-presidente analista do Gartner, observa que embora 67% dos líderes de cibersegurança digam que os riscos emergentes de GenAI exigem mudanças significativas nas abordagens atuais, é necessária uma estratégia mais equilibrada. Em vez de mudanças radicais ou investimentos isolados, organizações devem fortalecer controles centrais e implementar medidas direcionadas para cada nova categoria de risco.

O que você pode fazer para se proteger

Não são apenas empresas que precisam se preocupar. Consumidores comuns enfrentam ameaças cibernéticas cada vez mais complexas e personalizadas.

- Senhas fortes e únicas são mais importantes do que nunca. Criminosos usam a IA para testar credenciais vazadas em centenas de sites em minutos. Nunca repita a mesma senha em diferentes contas. Use combinações longas e únicas, e se possível, adote um gerenciador de senhas confiável para não precisar memorizar todas.

- Proteja seus dados pessoais online. Quanto menos informações suas estiverem expostas publicamente, mais difícil será para atacantes cruzarem dados de vazamentos com o que encontram em redes sociais ou bancos de dados públicos. Revise sua pegada digital periodicamente e considere serviços especializados de remoção de dados de brokers de informações.

- Ative a autenticação em dois fatores (2FA) em todas as contas que oferecem essa opção, especialmente bancos e serviços financeiros. Mesmo que sua senha vaze, um segundo fator pode bloquear acessos indevidos. Prefira aplicativos autenticadores ou chaves físicas em vez de SMS, que podem ser interceptados.

- Mantenha absolutamente tudo atualizado. Sistemas operacionais, aplicativos e dispositivos desatualizados são alvos fáceis porque criminosos conhecem as vulnerabilidades específicas de versões antigas. Ative atualizações automáticas sempre que possível para não depender de lembrar manualmente.

- Desconfie de mensagens urgentes, mesmo que pareçam vir de fontes legítimas. Golpes de phishing usam cada vez mais textos convincentes gerados por IA que imitam perfeitamente o estilo de escrita de empresas reais ou pessoas que você conhece. Não clique em links ou baixe arquivos sem verificar com calma a origem. Se uma mensagem cria senso de urgência, isso é exatamente quando você deve ir mais devagar e investigar.

- Use um antivírus confiável e o mantenha atualizado. Ataques com malware criado ou adaptado por IA estão mais sofisticados do que nunca. Um bom antivírus moderno ajuda a detectar ameaças emergentes e bloquear comportamentos suspeitos antes que causem danos, especialmente variantes polimórficas que mudam constantemente.

- Cuidado especial com deepfakes. Se você receber uma chamada ou mensagem de vídeo de alguém solicitando algo incomum, especialmente envolvendo dinheiro ou informações sensíveis, desconfie mesmo que pareça ser a pessoa real. Encerre a conversa e entre em contato com a pessoa por outro meio para confirmar a autenticidade da solicitação.