Os EUA Utilizaram utilizou o modelo de inteligência artificial Claude da Anthropic em Operação Militar realizada em 3 de janeiro de 2026 para capturar o então presidente da Venezuela, Nicolás Maduro, em Caracas, informou o jornal The Wall Street Journal neste sábado, citando múltiplas fontes familiarizadas com o assunto e oficiais do governo americano.

“O instrumento de inteligência artificial Claude, desenvolvido pela empresa Anthropic, foi empregado em uma operação militar norte-americana para capturar Nicolás Maduro, o que evidencia a crescente popularidade e adoção dos modelos de IA no Pentágono e nas forças armadas dos Estados Unidos”, afirma o artigo detalhado do Wall Street Journal baseado em informações de fontes internas do Departamento de Defesa.

A ferramenta de inteligência artificial generativa Claude, da startup de tecnologia Anthropic especializada em segurança de IA e no processamento avançado de dados, foi utilizada na operação militar por meio de uma parceria comercial com a empresa de análise de dados Palantir Technologies, cujas plataformas de software são amplamente utilizadas pelo Departamento de Defesa dos Estados Unidos e por diversas forças policiais e agências de segurança federais para integração e análise de grandes volumes de informação.

Violação de Políticas de Uso Aceitável da Anthropic

Segundo a publicação detalhada do Wall Street Journal, o veto explícito da desenvolvedora Anthropic ao uso do Claude em situações que envolvam violência, desenvolvimento ou uso de armas e atividades de vigilância levou o Pentágono a considerar seriamente romper um contrato de US$ 200 milhões, aproximadamente R$ 1,14 bilhão, com a empresa parceira Palantir Technologies, por meio da qual o Departamento de Defesa tinha acesso autorizado ao sistema de inteligência artificial da Anthropic.

Leia Também: Mrinank Sharma, Líder de Segurança IA da Anthropic, Renuncia com Carta Alertando que “O Mundo está em Perigo

Os termos de uso e políticas de uso aceitável da Anthropic, empresa que recentemente arrecadou impressionantes US$ 30 bilhões em sua última rodada de financiamento e agora está avaliada em US$ 380 bilhões tornando-se uma das startups mais valiosas do mundo, explicitamente proíbem que a ferramenta Claude seja utilizada para “facilitar a violência, desenvolver ou projetar armas, ou conduzir atividades de espionagem e vigilância”.

“Não podemos comentar se o Claude, ou qualquer outro modelo de IA desenvolvido por nós, foi usado para qualquer operação específica, classificada ou não classificada”, declarou cautelosamente um porta-voz oficial da Anthropic em resposta a questionamentos da imprensa.

“Qualquer uso do Claude, seja no setor privado comercial ou no governo federal, deve estar obrigatoriamente em conformidade com as nossas Políticas de Uso Aceitável, que regem estritamente como o Claude pode ser implementado e utilizado. Trabalhamos em estreita colaboração contínua com os nossos parceiros comerciais para garantir total conformidade com essas políticas”, acrescentou o porta-voz, sem confirmar ou negar especificamente o uso na operação venezuelana.

Detalhes da Operação de Captura em Caracas

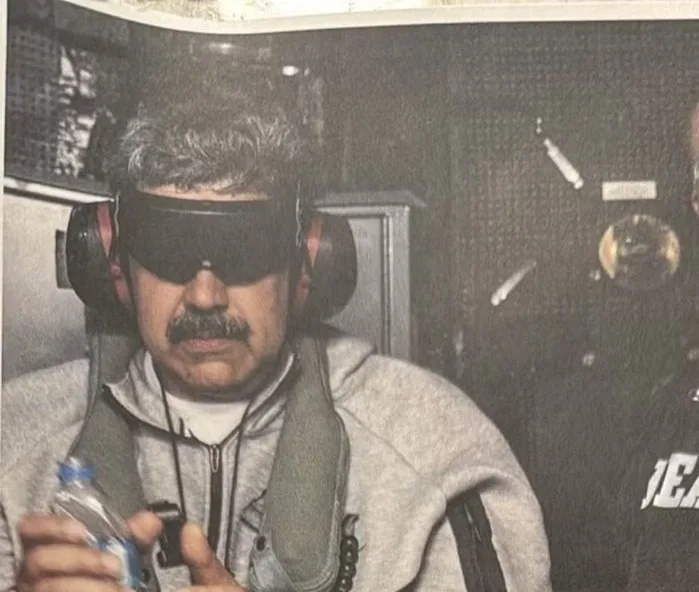

Em 3 de janeiro de 2026, os Estados Unidos realizaram uma operação militar audaciosa e sem precedentes contra Caracas, capital da Venezuela, capturando e detendo o presidente venezuelano Nicolás Maduro e sua esposa, Cilia Flores, em uma ação que incluiu o bombardeio estratégico de vários locais importantes na cidade.

A missão para capturar Maduro e sua esposa foi executada por forças especiais americanas e resultou em apenas sete militares dos EUA ficando feridos, segundo informações divulgadas pela imprensa americana.

Maduro e Flores foram subsequentemente transportados aos Estados Unidos para responder a acusações criminais federais graves de narcoterrorismo, conspiração para tráfico internacional de drogas e múltiplas violações de leis antidrogas americanas.

O ex-presidente venezuelano havia sido procurado há anos pelo Departamento de Justiça dos Estados Unidos por supostos vínculos com o tráfico de drogas através do território venezuelano.

Segundo informações obtidas pelo portal americano Axios através de duas fontes independentes do governo dos EUA que confirmaram o uso do modelo de IA durante a operação na Venezuela, o modelo Claude não foi utilizado apenas na fase de planejamento e preparação da operação, mas também ativamente no dia da execução da missão propriamente dita.

O portal Axios destacou, contudo, que não foi possível confirmar com precisão o papel exato e específico desempenhado pela ferramenta de inteligência artificial na captura bem-sucedida do ditador venezuelano.

As fontes ouvidas confidencialmente pelo portal Axios citaram que o histórico documentado do uso militar do Claude pelas forças armadas dos EUA inclui análise automatizada de imagens de satélite de alta resolução, processamento de inteligência de múltiplas fontes, correlação de dados de diferentes origens e assistência na tomada de decisões operacionais em tempo real.

Acesso Através da Parceria com a Palantir Technologies

A implementação prática do modelo de inteligência artificial Claude ocorreu especificamente por meio da parceria estabelecida da Anthropic com a empresa de análise de dados Palantir Technologies, cuja plataforma de software especializada é amplamente utilizada pelo Departamento de Defesa, pela inteligência dos Estados Unidos e por outras agências federais de segurança para integração, análise e visualização de grandes volumes de dados complexos.

A Palantir Technologies atua estrategicamente como parceira intermediária da Anthropic especificamente para permitir o uso controlado da tecnologia de IA Claude em ambientes militares restritos e redes classificadas de segurança nacional, integrando tecnicamente o modelo Claude às ferramentas e plataformas de software já amplamente utilizadas nas forças armadas americanas e no complexo sistema de defesa e inteligência nacional.

A Anthropic é atualmente a única desenvolvedora de grandes modelos de linguagem de IA generativa com acesso autorizado a sistemas confidenciais e redes classificadas do governo federal por meio de empresas parceiras terceirizadas como a Palantir, tornando-a excepcionalmente valiosa para aplicações de segurança nacional apesar das restrições da política de uso.

Pressão do Pentágono por acesso sem Restrições

O Pentágono está ativamente pressionando quatro das principais empresas de inteligência artificial do mundo, incluindo especificamente a OpenAI desenvolvedora do ChatGPT, a Anthropic criadora do Claude, o Google com seu modelo Gemini, e a xAI de Elon Musk com seu modelo Grok, para que disponibilizem suas ferramentas de inteligência artificial em redes classificadas de segurança nacional sem muitas ou nenhuma das restrições padrão de política de uso aceitável que essas empresas aplicam a usuários civis e comerciais, informou a agência Reuters com exclusividade na quarta-feira anterior.

O Departamento de Defesa está especificamente exigindo que as empresas de IA permitam que os militares usem suas ferramentas para “todos os fins legais” possíveis, incluindo explicitamente áreas controversas como desenvolvimento de sistemas de armas autônomas, coleta de informações de inteligência através de vigilância, e operações cinéticas em campo de batalha, mas a Anthropic tem consistentemente se recusado a concordar com esses termos amplos e o Pentágono está ficando progressivamente impaciente após meses de negociações sem progresso significativo, de acordo com a reportagem detalhada do site Axios publicada no sábado.

O Pentágono está considerando ativamente encerrar sua parceria indireta com a empresa de inteligência artificial Anthropic devido à insistência firme desta em manter algumas restrições importantes sobre como as forças armadas dos EUA utilizam seus modelos de IA, informou o Axios citando um funcionário sênior do governo com conhecimento direto das negociações.

Posição da Anthropic sobre Uso Militar

Segundo informações obtidas pelo portal americano Axios, um porta-voz oficial da Anthropic afirmou publicamente ao que a empresa definitivamente não discutiu o uso específico de seu modelo de IA Claude para operações militares particulares ou classificadas com o Pentágono ou qualquer outra entidade do Departamento de Defesa.

O porta-voz disse que as conversas em andamento com o governo dos EUA até o momento se concentraram exclusivamente em um conjunto específico e limitado de questões de política de uso aceitável, incluindo limites rígidos e não negociáveis em torno de armas totalmente autônomas capazes de selecionar e engajar alvos sem supervisão humana, e vigilância doméstica em massa de cidadãos americanos, nenhuma das quais estaria diretamente relacionada às operações militares em andamento no exterior.

“Qualquer uso do Claude, seja no setor privado ou no governo, deve cumprir rigorosamente nossas Políticas de Uso Aceitável, que governam como o Claude pode ser implementado. Trabalhamos de perto com nossos parceiros para garantir conformidade total”, reiterou o porta-voz em declaração.

A empresa mantém atualmente políticas escritas que explicitamente proíbem o uso do Claude para apoiar violência física, projetar ou desenvolver armas de qualquer tipo, ou realizar vigilância não autorizada de indivíduos.

Essas políticas foram estabelecidas pelos fundadores da empresa, incluindo o CEO Dario Amodei e a presidente Daniela Amodei, ambos ex-funcionários da OpenAI que deixaram aquela empresa em parte devido a preocupações sobre a segurança de IA e o alinhamento de valores.

Desenvolvimento de Ferramentas Customizadas para Militares

Muitas empresas líderes de IA estão ativamente desenvolvendo ferramentas customizadas e versões especializadas de seus modelos especificamente para as forças armadas dos Estados Unidos, a vasta maioria das quais está disponível apenas em redes não classificadas de nível secreto baixo, normalmente usadas para funções administrativas militares e planejamento não sensível.

A Anthropic permanece a única empresa com modelos disponíveis em ambientes classificados de alta segurança através de parceiros terceirizados como a Palantir e potencialmente outras empresas de defesa, mas crucialmente o governo federal ainda está tecnicamente sujeito às políticas de uso aceitável estabelecidas pela empresa desenvolvedora, criando uma tensão entre as necessidades operacionais militares e os compromissos éticos da empresa.

A OpenAI, por exemplo, reverteu recentemente sua política de longa data contra o uso em operações militares e assinou contratos com o Pentágono para fornecer versões customizadas do GPT-4 para análise de inteligência e outras aplicações não letais.

O Google também fornece tecnologia de IA para o Departamento de Defesa através de seu contrato controverso Project Maven, embora tenha enfrentado protestos internos significativos de funcionários sobre uso militar da IA.

Implicações Éticas e Legais do Uso Militar

O uso revelado do Claude na operação militar para capturar Maduro levanta questões éticas e potencialmente legais significativas sobre o cumprimento de políticas de uso aceitável e supervisão de como modelos de IA comerciais são utilizados por entidades governamentais.

Se confirmado que a Anthropic tinha conhecimento do uso militar planejado e não tomou medidas para prevenir violação de suas próprias políticas, a empresa poderia enfrentar críticas substanciais de grupos de direitos humanos, pesquisadores de ética em IA, e seus próprios funcionários.

Alternativamente, se o uso ocorreu sem conhecimento ou consentimento da Anthropic através da parceria com a Palantir, isso destacaria desafios fundamentais de aplicação de políticas de uso quando modelos são acessados indiretamente através de intermediários. Empresas de IA têm capacidade técnica limitada de monitorar ou controlar como seus modelos são usados uma vez que o acesso é concedido a parceiros corporativos ou governamentais.

A situação também ilustra tensões crescentes entre valores declarados de empresas de IA focadas em segurança como a Anthropic e as pressões econômicas e políticas para permitir usos militares lucrativos. Contratos governamentais representam oportunidades de receita substanciais, e recusar completamente o trabalho militar poderia colocar empresas em desvantagem competitiva contra rivais menos escrupulosos.

Reações de Especialistas e Defensores de Direitos Humanos

Especialistas em ética de IA e defensores de direitos humanos expressaram preocupações sobre o uso de sistemas de IA comerciais em operações militares, especialmente sem transparência adequada ou supervisão independente.

“O uso de modelos de linguagem em operações militares cinéticas estabelece precedentes perigosos”, comentou um pesquisador de ética em IA que preferiu não ser identificado. “Esses sistemas não foram projetados, testados ou validados para aplicações onde erros podem resultar em perda de vidas”.

Organizações de direitos humanos também questionaram a legalidade da operação em si sob direito internacional, independentemente do uso de IA. A captura de um chefe de estado estrangeiro em seu próprio território através de ação militar unilateral levanta questões sobre a soberania nacional e ao devido processo legal que vão muito além de considerações tecnológicas.

O Futuro das Políticas de Uso de IA Militar

O incidente provavelmente intensificará debates sobre como empresas de IA devem ou podem efetivamente governar o uso de seus modelos por atores governamentais e militares. Algumas possíveis resoluções incluem:

Proibições completas de uso militar: Algumas empresas como a Anthropic originalmente tentaram proibir completamente o uso militar, mas descobriram que tais políticas são difíceis de aplicar na prática, especialmente quando o acesso é fornecido indiretamente.

Restrições baseadas em casos de uso: Permitir alguns usos militares considerados defensivos ou humanitários (como análise de imagens médicas em hospitais militares) enquanto proíbem aplicações ofensivas ou letais. Isso requer linhas claras que podem ser difíceis de traçar.

Renúncia completa de controle: Algumas empresas podem decidir que uma vez que modelos são vendidos ou licenciados, elas não têm responsabilidade ou capacidade realista de controlar o uso subsequente. Isso elimina tensões mas levanta preocupações éticas.

Versões militares separadas: Desenvolver versões explicitamente militares de modelos com políticas diferentes, mantendo versões civis com restrições. Isso fornece clareza mas duplica esforços de desenvolvimento.

Resposta Oficial

O Departamento de Defesa dos EUA não respondeu imediatamente aos pedidos de comentário da Reuters, Associated Press e outros meios de comunicação sobre o uso relatado do Claude na operação venezuelana. A Casa Branca também não emitiu declaração oficial confirmando ou negando as informações publicadas pelo Wall Street Journal.

A Palantir Technologies, empresa intermediária que forneceu acesso técnico ao Claude para o Pentágono, também não respondeu a múltiplos pedidos de comentários enviados por jornalistas de diversos veículos de comunicação. A empresa tem histórico de recusar comentários sobre contratos específicos de defesa e inteligência citando preocupações de segurança nacional.

A ausência de negações oficiais de qualquer das partes envolvidas é interpretada por alguns observadores como confirmação implícita da substância da reportagem do Wall Street Journal, embora outros alertem contra ler muito em silêncios que podem simplesmente refletir políticas padrão de não comentar sobre operações classificadas.

Contexto mais Amplo de IA em Aplicações Militares

Este incidente ocorre em um contexto mais amplo de adoção acelerada de inteligência artificial por militares ao redor do mundo. O Departamento de Defesa dos EUA investiu bilhões de dólares em pesquisa e desenvolvimento de IA através de iniciativas como o Joint Artificial Intelligence Center (JAIC), agora reorganizado como Chief Digital and AI Office (CDAO).

Aplicações militares de IA incluem:

- Análise automatizada de imagens de satélite e reconhecimento de padrões

- Processamento de grandes volumes de inteligência de sinais

- Manutenção preditiva de equipamentos

- Simulações e treinamento

- Planejamento logístico otimizado

- Sistemas de armas autônomas ou semi-autônomas

Enquanto algumas dessas aplicações são relativamente não controversas, outras como armas autônomas letais têm sido alvo de campanhas internacionais por proibições ou regulamentações estritas. O uso de IA em operações de combate diretas cai em área cinzenta que muitos argumentam requer muito mais debate público e supervisão.

IA e a Responsabilidade Corporativa

A revelação do uso do Claude na operação de captura de Maduro destaca tensões fundamentais não resolvidas sobre a responsabilidade corporativa, ética de IA e aplicações militares de tecnologias comerciais. Enquanto empresas como Anthropic tentam estabelecer políticas de uso responsável, a realidade de como seus modelos são utilizados uma vez implantados pode divergir significativamente das intenções declaradas.

Para a Anthropic especificamente, o incidente representa teste significativo de seu compromisso com valores de segurança de IA e uso ético. Como a empresa responde – seja fortalecendo aplicação de políticas, modificando termos de contratos governamentais, ou potencialmente encerrando parcerias que permitem usos não autorizados – sinalizará suas prioridades reais entre princípios éticos e oportunidades comerciais lucrativas.

Para o setor de IA mais amplamente, o caso ilustra necessidade urgente de frameworks mais robustos para governança de IA em contextos militares e de segurança nacional, idealmente envolvendo não apenas empresas e governos mas também sociedade civil, especialistas em ética e direito internacional. Sem tais frameworks, incidentes similares continuarão ocorrendo, potencialmente com consequências cada vez mais graves conforme as capacidades da IA avançam.